Exploring Projekt

Ausgangssituation

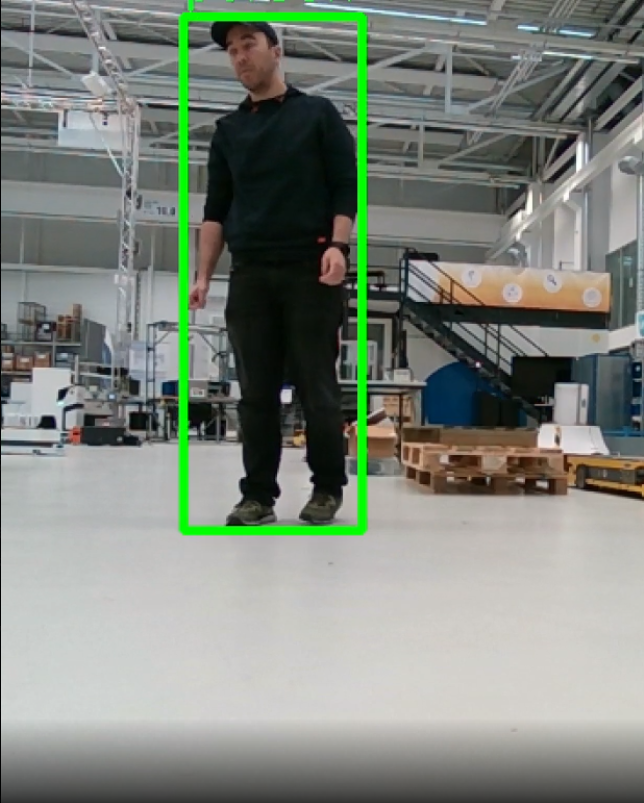

Autonome Mobile Roboter (AMR) führen Transportaufgaben in der Logistik selbstständig durch. Hierbei navigieren sie in einem dynamischen Umfeld (mit Routenzügen, Gabelstaplern, Personen etc.). Die autonome Navigation nutzt typischerweise 2D-Laserscanner zur Erfassung der Umgebung. Jedoch sind deren Umgebungsinformationen begrenzt, sodass keine zuverlässige Erkennung von Semantiken möglich ist.

Für einen reibungslosen Betrieb muss das Roboterverhalten aber situativ an das Umfeld angepasst werden, sodass bspw. Routenzüge Vorfahrt erhalten. Für Routenzüge, Gabelstapler etc. gibt es jedoch noch keine Objekt- oder Bilddatenbanken. Deshalb können verfügbare KI-Modelle diese Objekte noch nicht wahrnehmen.

Lösungsidee

Ein komplexes Verständnis der Umgebung kann mithilfe von visuellen Perzeptionsalgorithmen generiert und in einem vom Fraunhofer IPA entwickelten Umgebungsmodell verwaltet und analysiert werden. Dies wird ermöglicht, wenn es gelingt, State-of-the-art-KI-Methoden zu adaptieren, um die relevanten Objektklassen zu erkennen. Die Erkennungsalgorithmen sollten dann auf dem Roboter implementiert werden, um die Leistungsfähigkeit und Ausführungszeit zu beurteilen.

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«